La nueva forma de aprender de la #IA. ¿Conoces V-JEPA? 🤔

Esta investigación ha sido publicada por la empresa Meta y lleva detrás a grandes referencias de la IA como Christoph Feichtenhofer o Yann LeCun

Pero antes de explicar V-JEPA debemos saber un poco sobre su origen, es decir la arquitectura #JEPA, ya que la «V» viene de Visión y es aplicada al campo de la imagen.

✅ ¿Qué es #JEPA (Joint Embedding Predictive Architecture)?

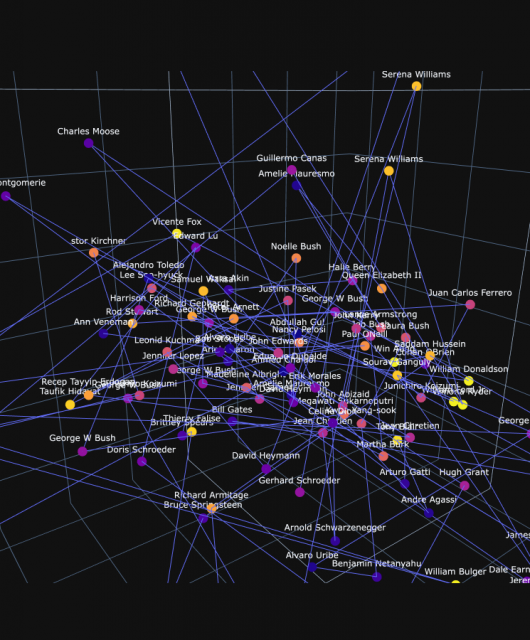

Imagina una escuela de arte donde te enseñan a dibujar y pintar no solo copiando directamente lo que ves, sino también imaginando cómo serían las cosas desde diferentes ángulos o en diferentes condiciones de luz, sin que el objeto esté presente frente a ti. La arquitectura #JEPA funciona de manera similar. En lugar de simplemente aprender a reconocer y replicar lo que ve directamente en los vídeos, #JEPA intenta predecir cómo serían las representaciones (o características) de ciertas partes del vídeo bajo diferentes transformaciones o cuando algunos elementos están ocultos.

Esta capacidad de predecir y entender las variaciones en los datos visuales, incluso cuando no están explícitamente presentes, es como un artista que entiende profundamente su objeto de estudio al punto de poder recrearlo bajo nuevas condiciones

✅ ¿Qué tiene de interesante la investigación V-JETA? 😮

La investigación «Revisiting Feature Prediction for Learning Visual Representations from Video» introduce un modelo que aprende representaciones visuales prediciendo características de vídeos sin supervisión explícita, es decir se refiere al proceso de entrenar modelos de inteligencia artificial para entender y codificar información visual de vídeos sin que se les indique específicamente qué buscar en estos datos. En lugar de usar etiquetas o anotaciones hechas por humanos para guiar el aprendizaje (supervisión explícita).

✅¿Cómo se entrena? 🤔

V-JEPA utiliza estrategias de enmascaramiento («Ablating Prediction Task»), para ocultar ciertas partes de los vídeos durante el entrenamiento. Luego intenta predecir estas partes ocultas basándose en el contexto visible.

Estás viendo una película con amigos, y de vez en cuando, alguien pasa por delante de la pantalla. Tu cerebro intenta llenar esos vacíos, recordando lo que sabe sobre la trama, los personajes y sus entornos, para mantener el hilo de la historia. Este proceso de «rellenar los huecos» es similar a cómo V-JEPA trabaja con bloques espacio-temporales aleatorios.

Al intentar predecir estas partes faltantes basándose en el contexto visible, V-JEPA aprende a comprender la importancia de diferentes elementos en el vídeo, cómo se relacionan entre sí a través del tiempo y el espacio, y cómo contribuyen al desarrollo de la escena o la historia

Estas técnicas seguro que os suenen en el campo del #NLP pero es realmente interesante como se ha podido llevar al campo de la visión.